HBM-PIM이란?

(High Bandwidth Memory - Processing in Memory)

메모리에 연산 작업 프로세서 기능을 더한 융합 기술로 AI 가속기 시스템에 활용된다.

HBM-PIM의 등장 배경

1세대 : 폰 노이만 구조

수학자이자 물리학자인 폰노이만과 다른 사람들이 1945년에 서술한 설명에 기반한 컴퓨터 아키텍쳐는 중앙처리장치(CPU), 메모리, 프로그램의 세 가지 요소로 구성되어 있다.

i) 컴퓨터에 명령하면, 메모리 반도체(DRAM)에 작업물이 올라가고, CPU로 이동한다.

ii) CPU는 들어온 작업물을 하나하나 처리한 후,

iii) 결과물을 하드 디스크(HDD, SDD)에 저장한다.

모든 것이 개인 컴퓨터 내에서 이루어졌기 때문에, 효율적으로 동작할 수 있었다.

2세대 : 클라우드 시스템, 데이터 센터

스마트폰의 등장으로 데이터의 유동성이 급증하였다.

기존에는 개인 컴퓨터에서만 이루어졌던 작업들이 스마트폰 시대에 돌입하면서 사진과 영상, 데이터를 공유하기 시작했다.

이로 인해 사람들은 중앙화된 데이터 처리 센터를 원하게 됐고, 그렇게 클라우드 시스템이 등장하게 되었다.

데이터 센터라고 해서 막 그렇게 거창한 것이 아니다.

초 대량의 메모리들을 건물 하나에 때려 박고 24시간, 365일 전기를 공급하면 그게 바로 데이터 센터이다.

아마존, 쿠팡, 구글 등 소위 빅테크 기업들은 다 각자의 데이터 센터를 가지고 있으며,

이때 메모리 반도체 제조업체인 삼성전자와 SK하이닉스가 이익을 많이 냈다.

3세대 : AI의 탄생

ChatGPT의 출현으로 AI 시대가 도래했고

단순 데이터 저장 및 전송같은 상호작용 뿐만 아니라,

데이터 센터 내에서 그간 학습한 내용을 기반으로 질문자의 의도까지 파악하는

CPU 역할까지 수행해야될 필요가 생겼다.

기존 방식

: HBM의 원리 검색 ▶ HBM 키워드가 들어 있는 모든 내용을 벌크로 갖다 줌.

AI 방식

: HBM의 원리에 대해 요약해 줘!

▶ 데이터 센터에 저장된 HBM 키워드 관련 책, 논문, 뉴스 등을 불러온다.

▶ 해당 내용 중 원리에 관한 내용만 추출

▶ 추출한 내용을 요약/정리하여 전달

(메모리엑세스 시간이 상대적으로 느림)

프로세서(CPU,GPU)는 메모리에서 데이터를 가져와서 처리를 할 때

데이터가 오는 속도가 프로세서의 처리속도를 못 따라가 병목이 생겼고,

CPU, GPU의 속도가 점점 높아지기 때문에

데이터 전송 속도를 높이기 위해 Bandwith(데이터가 가는 길)을 넓힐 수 밖에 없었다.

GPU의 재발견

AI 시대를 따라가기 위해 필요한 CPU와 DRAM을 전부 사들이는 건 비효율적이다(소요 비용이 너무 큼)

CPU : 일반적으로 적은 수의 코어를 가지고 있어, 작은 작업들을 매우 빠른 속도로 처리 가능

GPU : 대량의 코어를 가지고 있으므로 대규모 데이터 세트를 동시에 처리하는데 유용하다.

▶ 복잡한 작업은 CPU가 수행하고 대규모의 잔업들은 GPU가 담당

즉, CPU 하나와 GPU 여러 개로 구성!

하지만 아직 메모리 엑세스 문제가 해결되지 않음.

HBM-PIM의 구성

PIM(Precessing in Memory)

PIM : Processing in Memoy

PIM반도체

: 컴퓨팅(계산)과 메모리(데이터 저장) 기능을 하나의 칩 안에 통합하여 데이터를 처리하고 전송

기존의 폰 노이만 구조에서 CPU와 RAM 사이에 발생하는 병목현상을 해결할 수 있다.

위 사진의 구조를 보면,

데이터를 저장/전송하는 Memort Cell과 연산처리를 하는 Logic unit이 전부 칩 하나에 들어있는 것을 알 수 있다.

이렇게 DRAM 안에서 간단한 연산은 끝내버리니, 데이터 이동 횟수가 줄어들고 메모리 병목 현상을 줄일 수 있다.

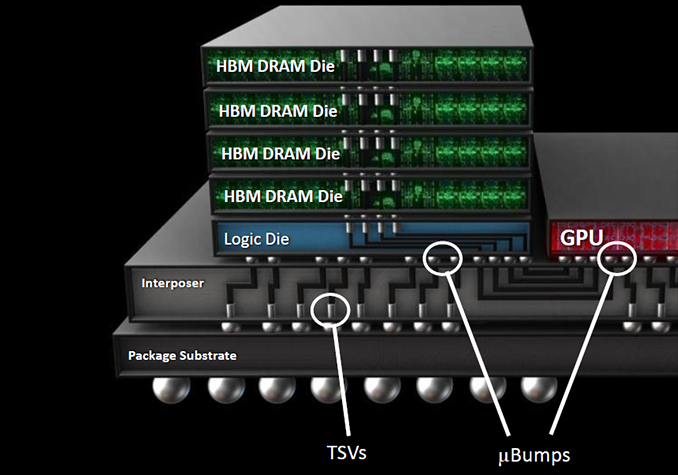

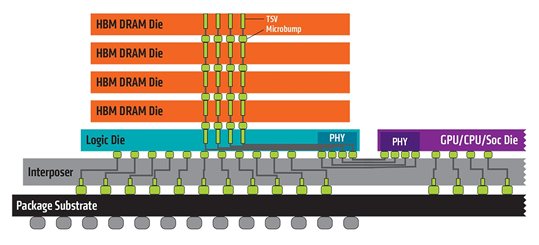

HBM(High Bandwidth Memory)

HBM의 핵심은 DRAM이 여러 개 적층되어 있는 형태로 구성되어 있다는 것이다.

HBM은 여러 개의 DRAM을 TSV(Through Silicon Via)를 통해 연결하고 후공정 기술이며 Advanced Package로 구현한다.

- TSV : 적층된 DRAM을 연결해주는 hole

HBM은 TSV를 이용하여 마치 차선 수가 증가된 고속도로를 구축한다.

당연히 차선이 많아지면 차들이 교통체증없이 빨리 다닐 수 있는 것처럼, 데이터 전송의 속도도 증가하게 된다.

또한 사이즈와 전력소모도 작게 제작할 수 있다는 장점을 가지고 있다.

▶ 32bit : 32차선, 1024bit : 1024차선

HBM-PIM

HBM으로 한 번에 많은 데이터를 옮기고, PIM으로 데이터 이동 횟수를 줄인다.

결국 그만큼 빠른 처리 속도로 소모 전력까지 감소시키는 효과를 얻을 수 있다.

해당 기술을 활용하면, 기존 메모리 대비 정보처리전력을 85% 이상 절감 가능하다

HBM의 활용

HBM은 원래 고성능 컴퓨터, 슈퍼컴퓨터에 사용되었지만

점점 대중화되고 있고 최근에는 인텔 사파이어 래피즈를 지원하고 모바일용도 곧 지원할 예정이다.

1. 5G 통신

: Sub6(3.5GHz대역, 4G보다 50%빠름), mmWave(28GHz 대역, 20배 이상 빠름)으로 구성되고 미국에서 곧 상용화될 것으로 보이는데 이것을 사용할 경우 처리해야할 데이터가 증가된다.

2. AI 데이터 처리

- SiRi와 같은 Al가 처리하는 정보를 데이터센터를 이용하는 것이 아니라 스마트폰 자체에서 처리를 하게 되고 모바일용 HBM이 중요함. 최근에 애플 A 바이오닉 시리즈, 삼성전자 엑시노스 AP에 NPU(Neural Processing Unit)를 채택함. NPU성능이 올라가고 코어수가 많아지면 HBM이 더 필요한 상황이다.

- 테슬라는 머신러닝을 활용하여 오직 카메라만으로 AI 기반 센싱을 하고 있음. 공급면에서 비용을 떨어뜨릴 수 있는 제조 경쟁력이 뒷받침이 되면 자율주행차는 물론 가전 제품에서도 HBM 적용은 시간 문제임.

3. 해상도 처리

- 폴더블폰이 대중화되면 8K 지원되는 스마트폰이 출시될 것이고 해상도 처리를 위해서도 HBM이 필요하다.

- 저가형 HBM은 PC 그래픽 카드 전용으로 개발 가능성도 있으며, 실제 삼성전자는 최근 엔비디아와 협력을 많이 하고 있는데 고성능 GPU에 HBM2 적용을 검토하고 있음.

'# Semiconductor > - 반도체 공정' 카테고리의 다른 글

| "MPW(Multi-Project Wafer) : 반도체 산업의 혁신과 미래" (0) | 2023.08.03 |

|---|---|

| 반도체 공정의 Game Changer, FC-BGA란? (0) | 2023.07.13 |

| 패키징 전쟁의 선두 주자, CoWos 기술(cf. 인터포저) (0) | 2023.07.12 |

| Chiplet 기술 - 후공정 기술의 대표주자 (0) | 2023.07.06 |

| 반도체 8대 공정 정리 (0) | 2023.07.04 |