[뉴런 모델]

뉴런과 시냅스의 동작 원리

뉴런은 뇌 및 신경계에서 정보를 전달하는데 사용되는 신경 세포이다.

뉴런은 다른 뉴런과 상호 작용하며 시냅스라고 하는 연결점을 통해 신호를 전달한다.

이 신호는 전기적인 화학적 변화로서 뉴런의 축삭 말단에서 시작되어

시냅스를 통해 다른 뉴런의 수상돌기로 전달된다.

그러나 이러한 신호가 다음 뉴런으로 전달되기 위해서는 일정한 전기적 프로세스가 필요하다.

1. Charge Accumulation(전하 축적)

뉴런의 세포막은 전기적으로 양성 또는 음성으로 불릴 수 있는 이온들로 구성되어 있다.

이러한 이온들은 뉴런 내외부 간에 높은 전기적 Gradient를 만들고

정지 상태에서 뉴런은 균형 상태를 유지하고 있으며 전기적으로 안정된 상태이다.

2. Firing(발화)

뉴런의 수상돌기에는 시냅스를 통해 전달되는 다른 뉴런의 신호를 감지하는 수용체가 있다.

이 수용체들은 화학적인 시냅스 전달 물질에 의해 활성화되어

이온 채널들을 열고 닫는데 영향을 미친다.

만약 축삭 말단에서 수상돌기로 전달되는 전기적 신호가 충분한 양의 자극을 초래한다면,

수상돌기 내의 이온 채널들이 열리고 전기적으로 불안정한 상태로 전이된다.

이러한 상태를 Action Potential이라 부른다.

3. Propagation(전파)

액션 포텐셜이 발생하면, 이는 수상돌기에서 축삭돌기까지 전기적으로 전달되어

다음 뉴런과의 시냅스 접촉점으로 전파된다.

이 때, 액션 포텐셜은 'All-or-None 원칙' 에 따라 전기적으로 간단한 형태로 유지된다.

즉, 액션 포텐셜은 크기가 일정하며 발생하는 자극의 세기와 관계없이 동일한 크기와 속도로 전파된다.

4. Affecting other Neurons(다른 뉴런에 영향)

액션 포텐셜이 다음 뉴런의 시냅스로 도달하면,

이는 화학적인 시냅스 전달 물질을 방출하여 다음 뉴런을 활성화시킨다.

이 과정에서 전기 신호가 화학 신호로 변환되어 다음 뉴런으로 전파되면서 정보가 전달된다.

이러한 방식으로 뇌의 다양한 영역에서 수억 개 이상의 뉴런들이 복잡하게 연결되어

함께 동작함으로써 우리가 인지, 감각, 학습 등 다양한 활동을 수행할 수 있다.

뉴런 모델

뉴런 모델이란?

생물학적 뉴런의 작동 원리를 수학적으로 모델링한 것으로, 인공지능 분야에서 널리 사용하는 개념이다.

뇌의 뉴런은 신호를 전달하고 처리하는데, 기본적인 단위로 작용하고

이러한 뉴런들이 복잡하게 연결되어 뇌의 기능을 구현한다.

가장 간단한 뉴런 모델은 매우 간단한 수학적 함수로 뉴런의 작동을 모사한다.

1) Input(입력)

: 뉴런에게 들어오는 입력 신호를 표현한다.

이 입력은 다른 뉴런으로부터 오는 시냅스를 통해 전달되며,

여러 개의 입력이 뉴런에 도착할 수 있다.

2) Weights(가중치)

: 입력에 곱해지는 가중치는 각 입력의 중요도를 조절한다.

이 가중치는 뉴런 학습 과정에서 조정되며,

뉴런이 어떤 패턴을 학습하는데 영향을 미친다.

3) Output(출력)

: 입력과 가중치의 조합으로 계산된 출력은

활성화 함수를 통과하여 다음 뉴런으로 전달된다.

활성화 함수는 일반적으로 비선형 함수로,

뉴런의 발화 여부를 결정한다.

즉, 뉴런 모델은 입력과 가중치를 조합하여 출력을 계산하는 과정을 수학적으로 표현한 것이다.

이러한 모델들을 여러 개 조합하거나 연결하여, 인공신경망(Atrificial Neural Network)을 구성하며,

이는 딥러닝과 같은 머신러닝 알고리즘에서 사용되어 다양한 문제를 해결하고 패턴을 학습하는데 활용한다.

뉴런 모델의 특징

- Neuron은 spiking neuron과 non-spiking neuron이 가능하다.

- Body : Soma / Input : Dendrite / Output : Axon / Synapse : Dendrite와 Axon의 연결부

- 신호를 보내는 경우, Presynaptic cell과 Postsynaptic cell로 구분된다.

- Pulse는 Action Potential 또는 Spike라고 부름

▶ 숫자와 Timing이 정보를 담고 있다.

- Absolute refractory period가 존재한다.

- 주위와의 전압 차이를 측정하게 되며, 이를 Membrane Potential(u(t))이라 한다.

- 자극이 없는 경우, U(rest)라는 constant membrane potential을 유지한다.

- 자극이 도착하면, potential이 증가하였다가 감소하게 됨.

- Spike after potential이 존재

- Event로만 취급되는 모델이 integrate-and-fire 모델이다.

- Leaky integrate-and-fire 모델이 간단한 형대이며, generalized integrate-and-fire model도 존재한다.

cf) Absolute refractory period

: 절대 무반응 기간으로, 뉴런이 하나의 스파이크를 발생시킨 후 다음 스파이크를 달생시킬 수 없는 시간 동안의 기간을 의미한다.

이 기간동안 뉴런은 자극에 반응하지 않으며, 어떤 강도의 입력 신호도 새로운 스파이크를 유발시킬 수 없다.

뉴런 모델 예시

아래 그림처럼 각 단계별로 뉴런 모델들이 구현되어 있으며

각 단계를 대표하는 몇 가지만 살펴보도록 하자.

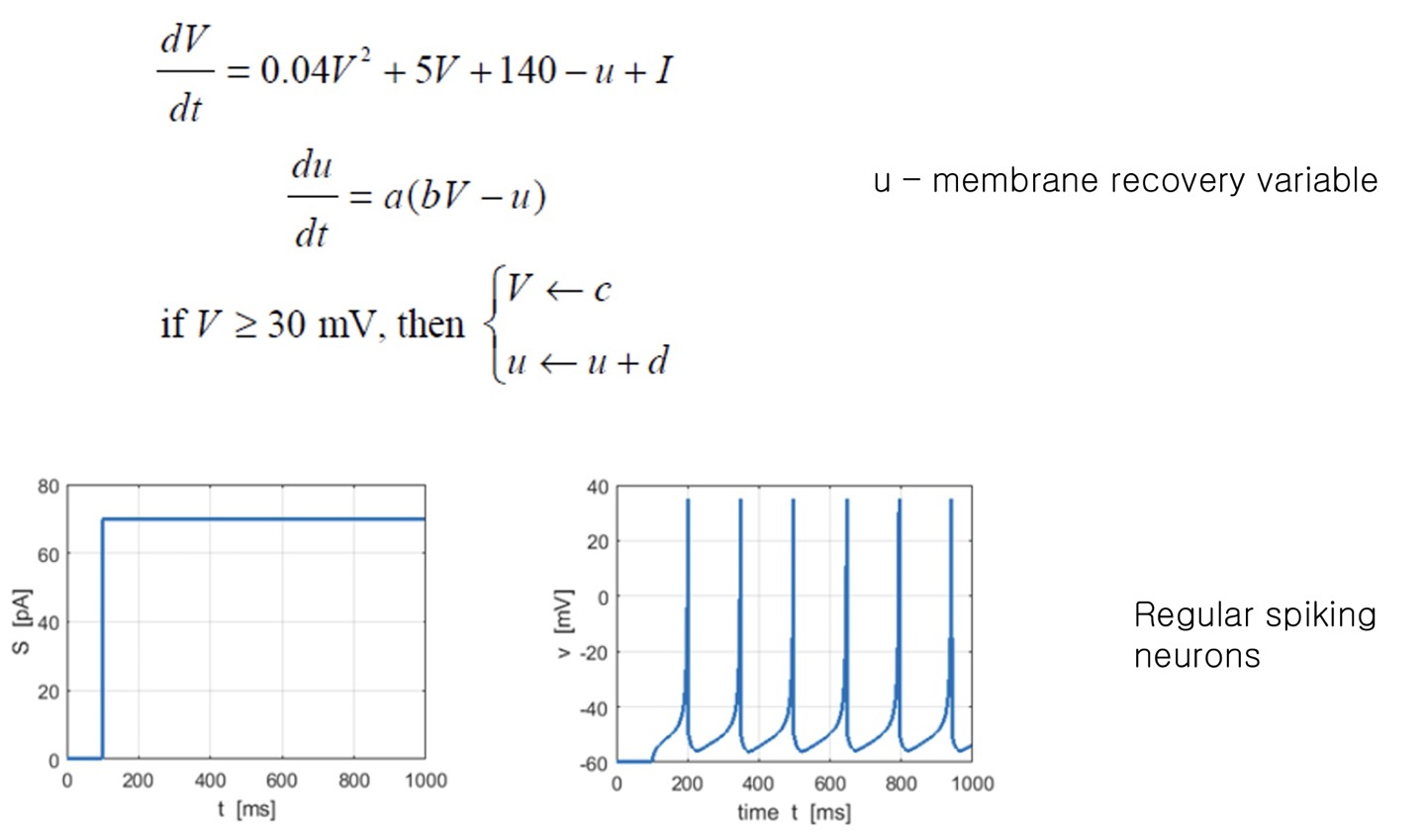

1) Biologically-inspired

→ Izhikevich spiking neuron model

▶ 모델 구조

: 두 개의 미분 방적식으로 구성되며,

하나는 뉴런의 막전위 / 다른 하나는 스파이킹 이벤트 포착

▶ 막전위

: 뉴런 내부 전위의 변화를 기술하며,

입력과 이온 전류에 의해 영향을 받는다.

▶ 스파이킹

: 뉴런 내부 전위가 정해진 임계값을 넘으면,

스파이크(파동)가 발생하고 막전위 초기화

2) Biologically-Plausible

→ Hodgkin-Huxley model

▶ 모델 구조

: 네 개의 미분 방적식으로 구성되며,

나트륨(Na+), 칼륨(K+) 이온 채널의 활성/비활성 상태를 기술한다.

▶ 이온 채널의 동작

: 전기 자극에 의해 이온 채널들이 열리고 닫히는 과정을 통해

뉴런의 전위 변화를 모델링한다.

▶ Action Potential

: 입력 전기 자극이 일정 임계값을 초과하면,

액션 포텐셜이 발생하여 뉴런의 전기적 신호가 전파된다.

3) Integrate-and-Fire Neurons

→ leaky integrate-and-fire neurons

digital spiking neuron model도 가능하다.

▶ 모델 구조

: LIF 뉴런은 막전위의 누적과 방전을 단순한 수학적 방정식으로 모델링한다.

▶ 막전위 누적

: 뉴런은 입력된 시냅스의 가중치에 따라 막전위를 누적시키는데,

이때 막전위는 시간이 지남에 따라 서서히 누출된다.(Leaky)

▶ 발화 여부

: 누적된 막전위가 정해진 임계값을 초과하면

뉴런은 스파이크(액션포텐셜)을 발생시키고 막전위는 초기값으로 재설정된다.

▶ 단순성과 효율성

: LIF 뉴런은 계산이 간단하고 빠르며, 다양한 신경망 모델에 효과적으로 적용됨

[시냅스 모델]

시냅스 모델이란?

인공지능에서 사용되는 두 뉴런 간의 연결 부분을 모델링한 것이다.

시냅스 모델의 특징

① Feed-forward neural network를 위한 간단한 구조와

실제 synapse와 유사한 구조가 가능하다.

② Neuromorphic system에서 많은 공간을 차지하고

이를 해결하기 위해 Memristor, ReRAM, MRAM 등을 사용한 시냅스가 연구되고 있다.

③ Plasticity mechanism(Learning algorithm)을 적용하면,

좀 더 복잡한 시냅스 모델을 만들 수 있다.

④ Biologically-inpired model의 경우, ion channels 등을 구성하게 되며

이는 Conductand-based synapse modelf로 구현된다.

⑤ Short-term과 Long-term 강화와 약화가 존재한다.

⑥ Non-spiking neural networks도 가능하다.

Feed-forward multi-layor networks, winner-take-all,

convolutional neural networks를 구현하는데 사용된다.

⑦ 다양한 learning rules가 가능하며, Hebbian learnin, least mean square 등이 존재한다.

[Learning Algorithm]

Neuromorphic Learning Algorithm은 인공 신경망과 달리, 신경과학에서 영감을 받아 만들어진 학습 알고리즘으로

뇌의 작동 방식을 모방하려고 시도하는 방법이다.

뉴로모픽은 "뉴런과 유사한(Neuromorphic)"이라는 의미로 뇌의 뉴런과 시냅스의 동작을 본뜬 시스템을 의미하고

뇌의 학습 원리와 뉴런 간의 시냅스 연결 강도 조정 등을 기반으로 학습한다.

Learning Algorithm은 다양한 모델들 사용이 가능하다.

1. Supervised learning

- Back-propagation off-line 이 가장 많이 사용됨(Host PC가 존재)

- On-line back-propagation 관련된 hardware가 가능하다.(Least mean-square 사용)

2. Unsupervised learning

- 초기에는 self-organizing learning rules를 사용하였다.

후반에는 Hebbian-type learning rules가 STDP와 함께 사용되고 있다.

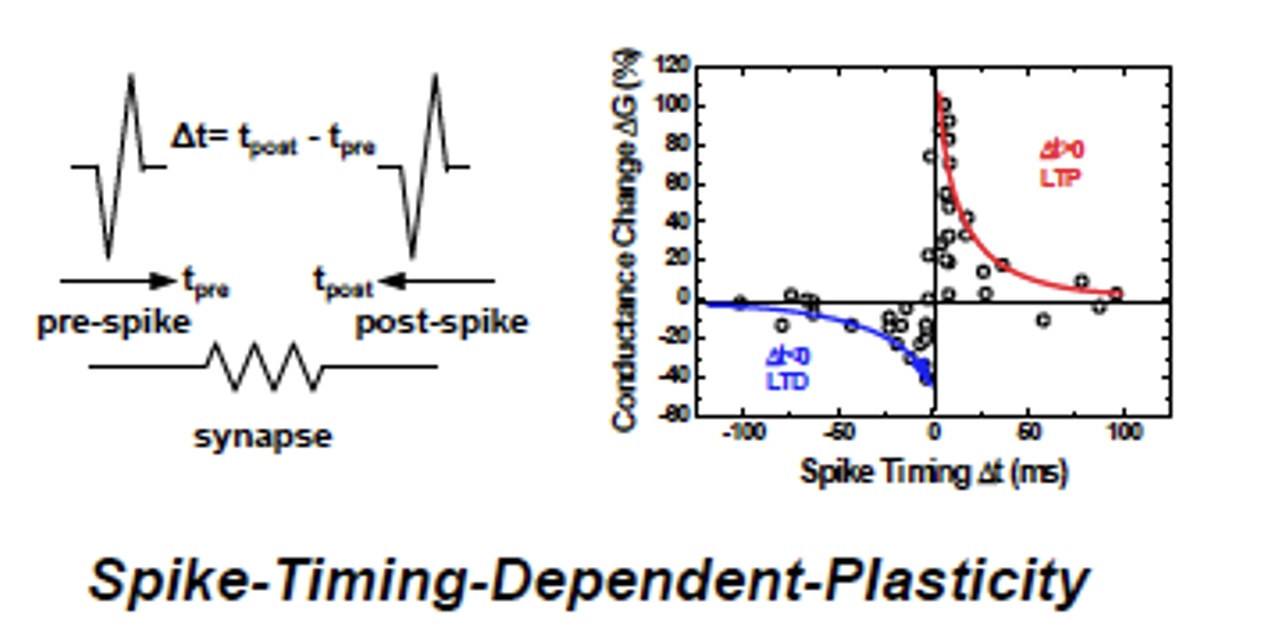

3. STDP

- STDP에 의한 학습이 가능하며, Pre-spike와 Post-spike의 시간 차이에 의해 synapse의 연결 강도가 달라진다.

- STDP는 pre-synaptic neuraon이 Firing하는 시간과 Post-synaptic neuron이 firing하는 시간 간격이

짧을수록 synapse의 weight가 크게 증가되며, Hebbian learning rules와 비슷한 내용이다.

[뉴로모픽 구조]

뉴로모픽의 기본 구조

▶ 뉴런은 spike를 기반으로 신호를 주고 받으며, 이 신호는 synapses의 정보에 의해 더해지거나 빼진다.

▶ 두 가지 동작이 가능하며, "Learning", "Operation" 으로 정의할 수 있다.

- Learning의 경우에는 synapses의 weight를 변경해 주는 과정

- Supervised와 Unsupervised learning이 존재한다.

▶ Randm weight change 알고리즘이 일반적으로 사용되며,

출력을 아는 경우 Error에 따라 weight를 변경해 준다.

Perceptron

퍼셉트론은 인공 신경망의 가장 기본적인 형태이며,

오늘 날의 인공신경망에서 이용하는 구조는 1958년 Frank Rosenblatt에 의해 제안되었다.

Rosenblatt은 Perceptron이라는 선형 분류기를 제안했는데, 이는 Input과 Weight들의 곱을 모두 더한 뒤

활성화 함수(Activation function)를 적용해서 그 값이 0보다 크면 1, 0보다 작으면 -1을 출력하는 선형분류 구조였다.

퍼셉트론은 간단하고 효과적인 알고리즘으로, AND, OR, NOT 등의 논리 연산을 수행하는데 사용되고

단층 퍼셉트론은 선형 분리 가능한 문제만 처리 가능, 다층 퍼셉트로은 여러 개의 층으로 구성되어

복잡한 비선형 문제도 해결할 수 있다.

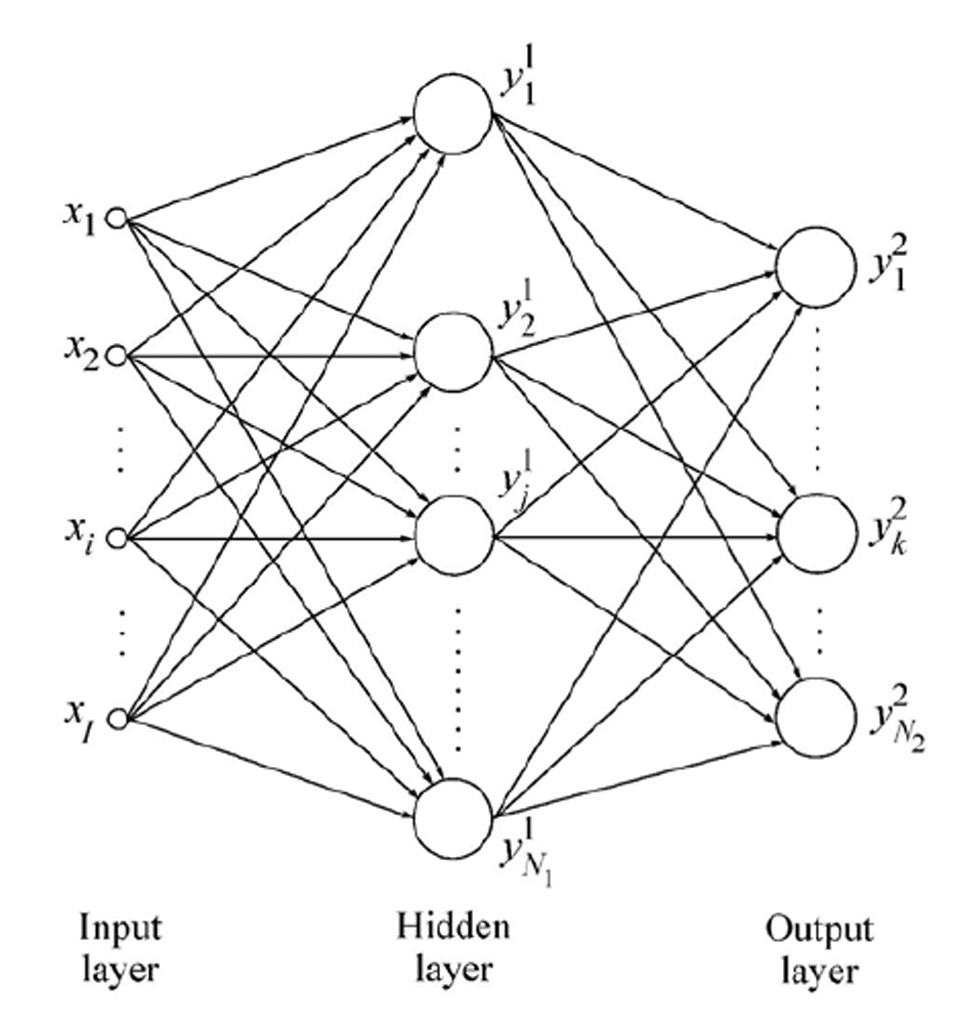

Multi-layer perceptron(MLP)

MLP는 여러 개의 Hidden layer(은닉층)를 포함한 다층 퍼셉트론 구조를 가지며,

입력층(input layer), 은닉층, 그리고 출력층(Output layer)으로 구성된다.

각 은닉층과 출력층은 여러 개의 뉴런으로 구성되고, 각 뉴런은 입력과 가중치의 선형 결합을

비선형 활성화 함수를 거쳐 출력을 계산한다.

MLP는 복잡하고 비선형적인 문제를 효과적으로 해결할 수 있으며,

이미지 인식, 자연어 처리, 음성 인식 등 다양한 분야에서 사용되는 딥러능 모델 중 하나이다.

'# Ai > - Neuromorphic' 카테고리의 다른 글

| <뉴로모픽 시스템에 대하여> Part.3 (Verilog HDL을 활용한 뉴런, 디지털 시냅스의 설계, Learning Algorithm) (0) | 2023.07.31 |

|---|---|

| <뉴로모픽 시스템에 대하여> Part.1 (뉴로모픽 컴퓨팅, Neural Network, SNN, 뉴로모픽 칩 등) (0) | 2023.07.26 |